DevStar AI+ DevOps

DevStar AI+ DevOps 是一个完整的AI驱动研发平台解决方案,通过集成 DevStar平台、代码大语言模型、Gitea MCP Server和 AI Code Tools(Cursor、Claude Code、iFlow等),为开发者提供智能化研发支撑体系。

🚀 快速部署配置指南

一、部署 DevStar 代码托管平台

Ubuntu-20.04下完成安装:

wget -c https://devstar.cn/assets/install.sh && chmod +x install.sh && sudo ./install.sh

sudo devstar start安装完成后,我们得到DevStar代码托管平台的URL,比如http://172.16.94.26:80 ,之后作为 GITEA_HOST(给 MCP Server 用)

二、Ollama私有部署代码大模型

如您使用第三方API及Token,比如从智谱AI开放平台 上注册申请并添加新的API Key,可以跳过这一部分。

Ubuntu-20.04下完成安装:

curl -fsSL https://ollama.com/install.sh | sh

# 验证是否安装成功

ollama --version

# 下载Qwen2.5-Coder大模型

ollama pull qwen2.5-coder:32b

# 列出已下载的模型

ollama list

# 测试模型

ollama run qwen2.5-coder:32b "Hello, can you help me code?"

# 启动Ollama服务 (默认端口11434)

ollama serve

# 验证服务状态

curl http://172.16.94.26:11434/api/tags- 解决Ollama只能本地访问的问题

# 添加环境变量OLLAMA_HOST=0.0.0.0和OLLAMA_ORIGINS=*

sed -i '/\[Service\]/a Environment=OLLAMA_HOST=0.0.0.0' /etc/systemd/system/ollama.service

sed -i '/\[Service\]/a Environment=OLLAMA_ORIGINS=*' /etc/systemd/system/ollama.service

# 重新加载并重启

systemctl daemon-reexec

systemctl daemon-reload

systemctl restart ollama产出

- 模型服务地址,例如:

http://172.16.94.26:11434 - 模型名,例如:

qwen2.5-coder:32b

后面用在哪里

- CI/CD 里的 AI Code Review(作为

vars.MODEL/vars.OLLAMA_HOST)

三、在项目中使用代码大模型

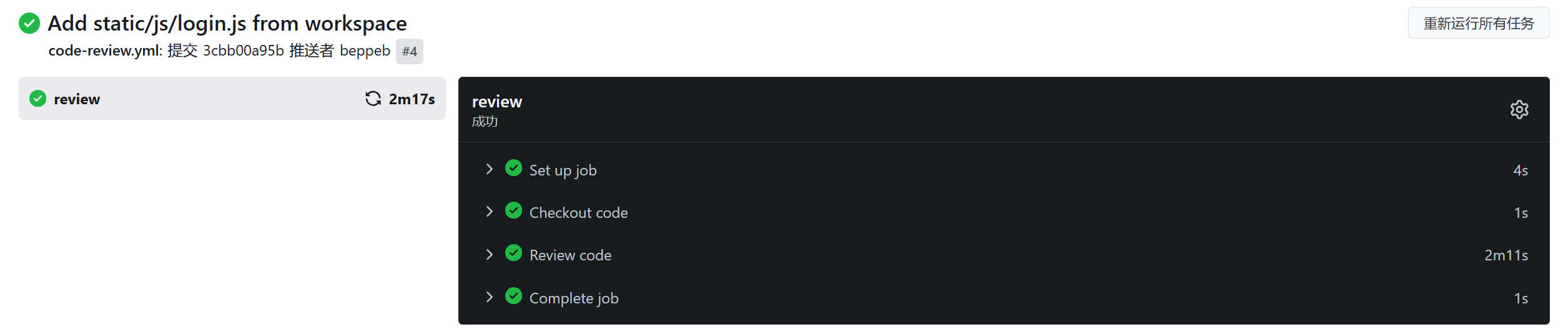

配置AI Code Review到CI/CD工作流中

在您的项目中添加.gitea/workflows/code-review.yml , 这里使用kekxv/AiReviewPR@v0.0.6来进行AI Code Review

name: ai-reviews

on:

pull_request:

types: [opened, synchronize]

jobs:

review:

runs-on: ubuntu-latest

steps:

- name: Checkout code

uses: actions/checkout@v4

with:

fetch-depth: 0

- name: Review code

uses: kekxv/AiReviewPR@v0.0.6

with:

model: ${{ vars.MODEL }}

host: ${{ vars.OLLAMA_HOST }}

REVIEW_PULL_REQUEST: false

//如果用ai token 则需配置

//ai_token: ${{ vars.AI_TOKEN }}然后在 DevStar 平台上您的项目仓库【设置 > 工作流】 里设置变量或密钥:

vars.MODEL:填入 第二步中的模型名,例如qwen2.5-coder:32bvars.OLLAMA_HOST:填入 第二步中得到的模型服务地址 例如http://172.16.94.26:11434vars.AI_TOKEN:填入 第二步中第三方获取的API Key token

安装配置MCP Server

在 VS Code 中使用,要快速安装,请使用如下安装按钮。

也可以在项目中添加到 .vscode/mcp.json 文件如下:

{

"inputs": [

{

"type": "promptString",

"id": "gitea_token",

"description": "Gitea 个人访问令牌",

"password": true

}

],

"servers": {

"gitea-mcp": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"-e",

"GITEA_HOST",

"-e",

"GITEA_ACCESS_TOKEN",

"docker.gitea.com/gitea-mcp-server"

],

"env": {

"GITEA_HOST": "<Your Gitea Host>",

"GITEA_ACCESS_TOKEN": "${input:gitea_token}"

}

}

}

}GITEA_HOST:第一步中得到的 DevStar 代码托管平台地址

gitea_token:来自 DevStar / Gitea 的「个人访问令牌」

获取方式:

- 登录 DevStar 平台 (

GITEA_HOST对应的网站) - 进入:右上角用户 【设置 > 应用】中

- 点击「生成新的令牌」,命名令牌并给予仓库读取等必要权限

- 复制生成的一串字符串,这就是你的

gitea_token

配置 AI IDE/CLI 使用 LLM 及 MCP Server

- LLM

- 使用第三方 API/云端模型(OpenAI/Anthropic/Azure/Gemini)

- Cursor:在模型设置中选择对应 Provider,配置 API Key / Base URL / Model

- Continue:Add Chat model 选择对应 Provider,配置 API Key / Base URL / Model

- Copilot:在“管理模型”中选择 Copilot 支持的云端模型(若需使用自带 Key 的第三方,一般用 Cursor/Continue 接入更直接)

- 使用本地/私有部署(Ollama / 内网 LLM)

- Copilot:在“管理模型”中选择 ollama

- Continue:Add Chat model → Provider 选择 ollama

- Cursor:若 LLM 在内网且 Cursor 不支持直连,需要做反向代理/企业网关提供公网可访问的 Base URL 再接入

- 使用第三方 API/云端模型(OpenAI/Anthropic/Azure/Gemini)

- MCP Server(与 LLM 选择无关)

- Copilot(VS Code):将 MCP 配置添加到 .vscode/mcp.json

- Cursor:Cursor Settings → Tools & MCP → New MCP Server,将 MCP 配置写入 mcp.json

- Continue:Settings → Tools → MCP Servers 配置 YAML ,或复用 Cursor 的 MCP 配置:将 mcp.json 放到 .continue/mcpServers/mcp.json

🚀 DevStar AI+ DevOps演示

在前面部署配置的基础上,我们以VSCode + Copilot或者Continue等为例,演示AI生成代码、触发CI/CD工作流及AI Code Review

创建一个项目

点击右上角创建仓库->DevStar模板中选择Devstar.cn/template/ai-develops

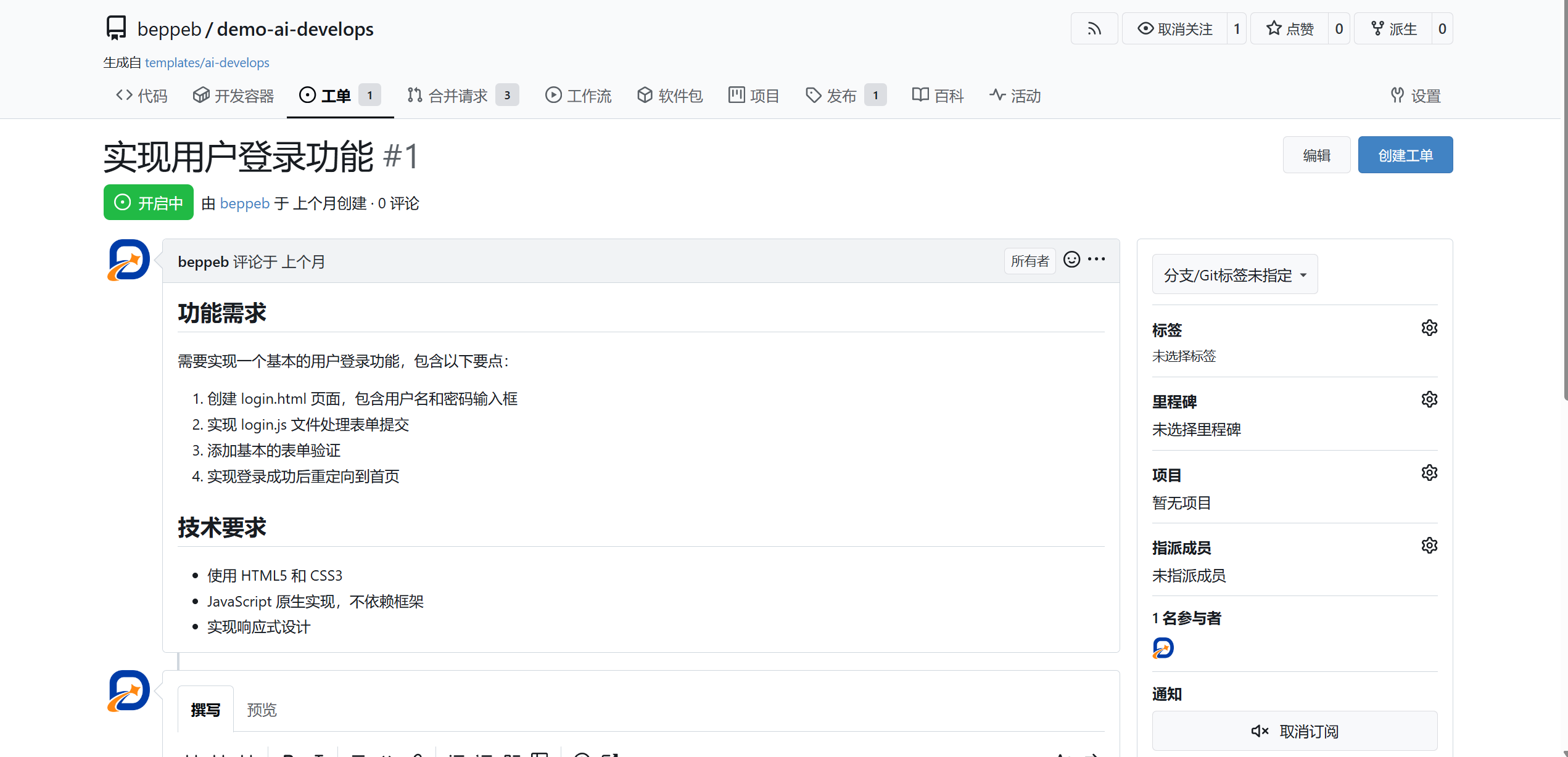

在项目中创建一个issue

AI生成代码

1.请在 Gitea 仓库 owner/repo 中读取 issue #1,帮我用自己的话总结问题、预期行为,并给出一个简单的解决思路。

2.请根据你对 issue #的理解实现这个功能

3.请为这次修复 issue #1 的改动补充或更新测试代码,遵循项目的现有测试风格,并说明每个测试在验证什么行为。

提交PR

1.请使用 Gitea MCP 为 issue #1创建一个新分支(如 fix/issue-1),将本次所有相关修改提交为一个清晰的 commit

2.请使用 Gitea MCP 从你刚才创建的分支向 main 分支发起一个 PR,标题中包含 “#1”,描述中简要说明问题、解决方案、主要改动和测试情况,并把 PR 的链接或编号发给我。

AI Code Review